最近,我们的一位读者问我们如何优化robots.txt文件以提高SEO。

该robots.txt文件告诉搜索引擎如何抓取你的网站,这使它成为一个令人难以置信的强大的SEO工具。

在本文中,我们将向您展示如何为SEO创建一个完美的robots.txt文件的一些技巧。

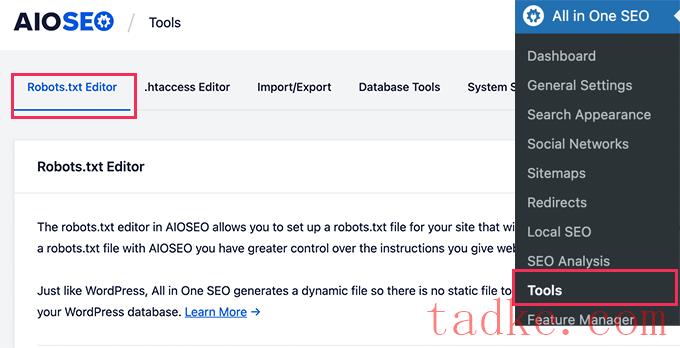

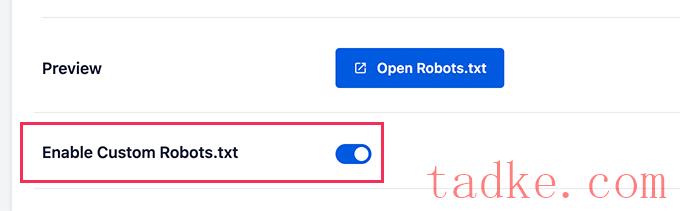

首先,您需要打开编辑选项,方法是将“Enable Custom robots.txt”切换为蓝色。

有了这个开关,你就可以在WordPress中创建一个定制的robots.txt文件。

All in One SEO将在屏幕底部的‘robots.txt预览’部分显示您现有的robots.txt文件。

此版本将显示WordPress添加的默认规则。

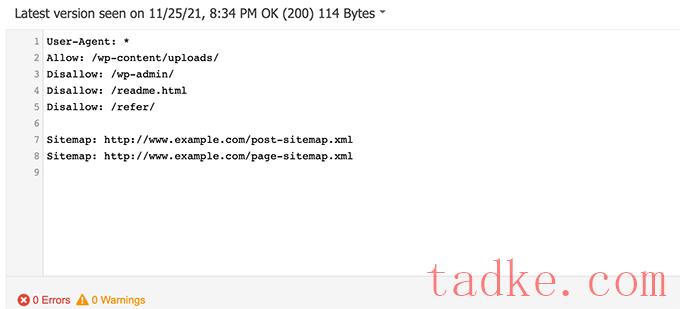

这些默认规则告诉搜索引擎不要爬行您的核心WordPress文件,允许机器人对所有内容进行索引,并为它们提供指向站点的XML站点地图的链接。

现在,您可以添加自己的定制规则来改进用于SEO的robots.txt。

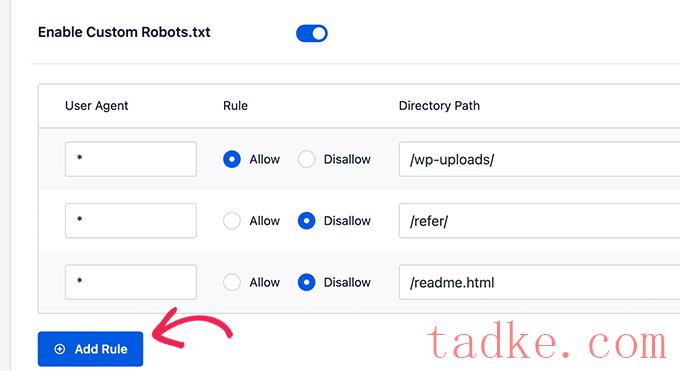

要添加规则,请在“用户代理”字段中输入用户代理。使用*将规则应用于所有用户代理。

然后,选择是否允许或禁止搜索引擎爬行。

接下来,在“目录路径”字段中输入文件名或目录路径。

该规则将自动应用于您的robots.txt。若要添加其他规则,只需单击“添加规则”按钮。

我们建议在创建我们上面共享的理想robots.txt格式之前添加规则。

您的自定义规则将如下所示。

一旦你完成了,不要忘记点击‘保存更改’按钮来保存你的更改。

方法2.使用ftp手动编辑robots.txt文件

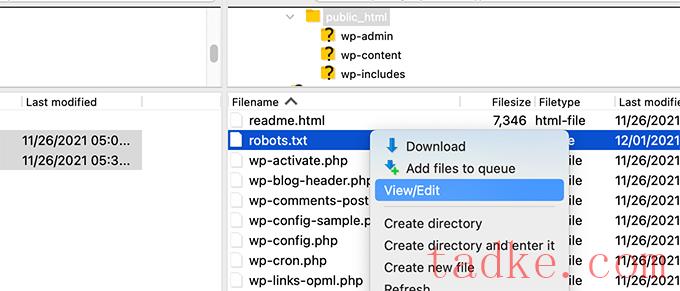

对于此方法,您将需要使用FTP客户端来编辑robots.txt文件。

只需使用FTP客户端连接到您的WordPress网站文件。

一旦进入,您将能够在您网站的根文件夹中看到robots.txt文件。

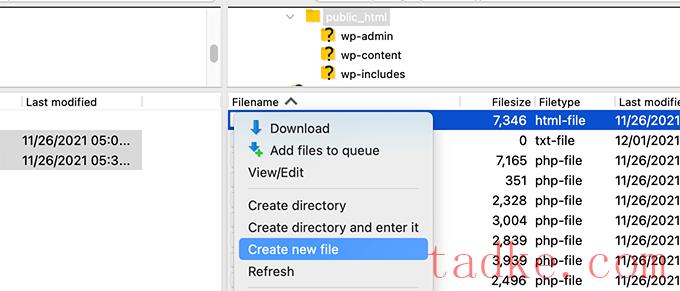

如果您没有看到,那么您很可能没有robots.txt文件。

在这种情况下,您可以继续创建一个。

Robots.txt是一个纯文本文件,这意味着你可以将其下载到你的电脑上,然后使用记事本或文本编辑等任何纯文本编辑器对其进行编辑。

保存更改后,您可以将robots.txt文件上传回网站的根文件夹。

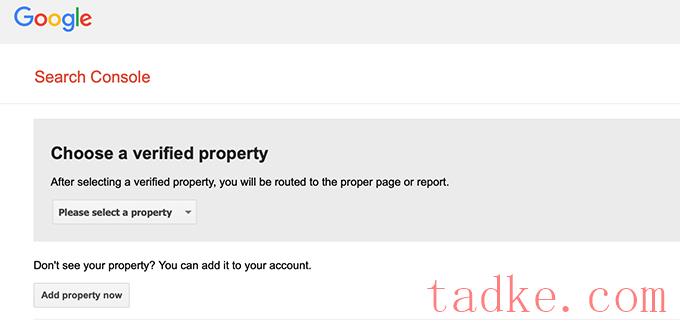

只需从下拉列表中选择您的物业即可。

该工具将自动获取您的网站的robots.txt文件,并突出显示错误和警告,如果它发现任何。

最后的想法

优化robots.txt文件的目标是防止搜索引擎抓取未公开提供的页面。例如,wp-plugins文件夹中的页面或WordPress管理文件夹中的页面。

SEO专家普遍认为,屏蔽WordPress类别、标签和档案页面会提高爬行率,导致更快的索引和更高的排名。

这不是真的。这也违反了谷歌的网站管理员指导方针。

我们建议您按照上述robots.txt格式为您的网站创建一个robots.txt文件。

我们希望本文能帮助您了解如何针对SEO优化您的WordPress robots.txt文件。你可能还想看看我们的终极WordPress SEO指南,我们的专家挑选了最好的WordPress SEO工具来发展你的网站。

中国和中国都是如此。