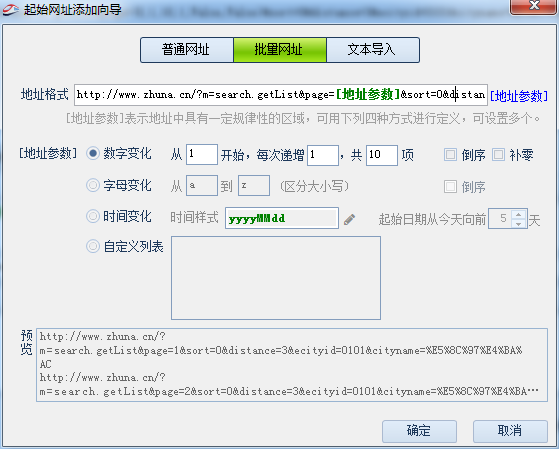

火车头采集器DedeCMS5.6免登陆文章发布接口使用说明 一、火车头采集器DedeCMS5.6免登陆文章发布接口功能特性 1、免登陆,用户可以设置验证密码来防止未授权的访问. 2、多用户随机发布文章. 3、可以达到和手工发布文章完全一样的效果,包括是否生成静态,去掉外链,下载远程图片等功能. 二、火车头采集器DedeCMS5.6免登陆文章发布接口使用教程 1、文字教程 1.1、选择您网站对应的接口文件.如您网站是gbk编码,请选择 jiekou_gbk.php. 1.2、打开接口文件,修改验证密码,然后保存. 1.3、修改接口文件名并上传至网站的管理目录.如默认的dede目录. 1.4、修改发布模块 DedeCMS 5.6 免登陆接口文章发布模块.cwr ,将发布模块里的发布文件地址后缀及刷新列表文件地址后缀中的文件名修改为您刚才修改的接口文件名. 1.5、设置发布配置,采集并开始发布. 三、火车头采集器DedeCMS5.6免登陆文章发布接口注意事项 1、该接口仅适用于发布文章到DEDECMS频道内容模型为普通文章的栏目; 2、该接口基于DedeCMS 5.6 GBK版制作,适用于dedecms5.6 GBK/utf-8/BIG5等版本,请在使用时接口选择不同的版本. 3、分页代码 4. 默认接口以id为1的管理员发文章,如果要修改,请修改插件中的userID的值为新的管理员的id $cuserLogin = new userLogin(); $cuserLogin->userID = 1; 四.火车头采集器DedeCMS5.6免登陆文章发布接口参数说明 1、必选参数 title 标题 body 内容 typeid 主栏目ID,必填,可在后台网站栏目管理处查看该id username 用户名,必须使用网站上已存在的用户名,默认是随机用户名,用户需要在模块中设置 pw 验证密码.在刷新列表和post发布时使用,需要模块和接口中的验证密码一致. 2、可选参数 ishtml=1 是否生成HTML,1为是,0为否; remote=1 是否下载远程图片和资源,1为是,0为否 dellink=0 是否删除非站内链接,1为是,0或空为否; shorttitle 简略标题 […]